Ez lesz a teljes bemutató telepítése OpenStack (minimális config). Nagyon szeretném kipróbálni a nyílt forráskódú felhő operációs rendszert, és az OpenStack az egyik komoly megoldás, amelyet sok intézmény és vállalkozás használ. A Cern az egyik a felhasználók között, a Red Hat pedig az OpenStack erős támogatója.

légy tudatában: még azután is, ez a “vasalt ki” tutorial, akkor üdvözölte a hibákat, miután beállította mindent, és meg kell, hogy a kutatás több, hogy az OpenStack dolgozni ok. Néhány problémáról még néhány gyors útmutatóban írok.

az OpenStack hírneve az is, hogy telepítése és karbantartása bonyolult, és nem túl stabil. Sokat olvastam az OpenStack témában, sok dokumentáción mentem keresztül, és ez az eredmény. Ez magában foglalja a Vonatkioldás kézi telepítését, és ez a kiterjedt sorozat a minimális OpenStack telepítés minden összetevőjét lefedi (ne hagyja, hogy ez a minimális megtévesszen, rengeteg tennivaló van).

van néhány különbség az OpenStack hivatalos dokumentációja és maga a telepítés között, ezért ez az oktatóanyag számtalan órát takaríthat meg a hibák keresésével és a hibák megfejtésével.

az eljárás unalmas, de nagyon ajánlom, mivel a végén jól meg fogja érteni az OpenStack alapelveit.

többet a témáról legközelebb, menjünk dolgozni.

van egy tanulási görbe, és amit olvastam, azt hiszem, hogy az OpenStack ebben a pillanatban stabil megoldás a felhő igényeinek.

de, majd meglátjuk az út mentén, lehetővé teszi, hogy belevetik magukat.

előfeltételek

a CentOS 7-et fogom használni a telepítéseimhez (v.1908). Én lesz létre a labor VMware Fusion / munkaállomás. A CentOS kezdeti telepítése minimális GUI vagy bármilyen kiegészítés nélkül.

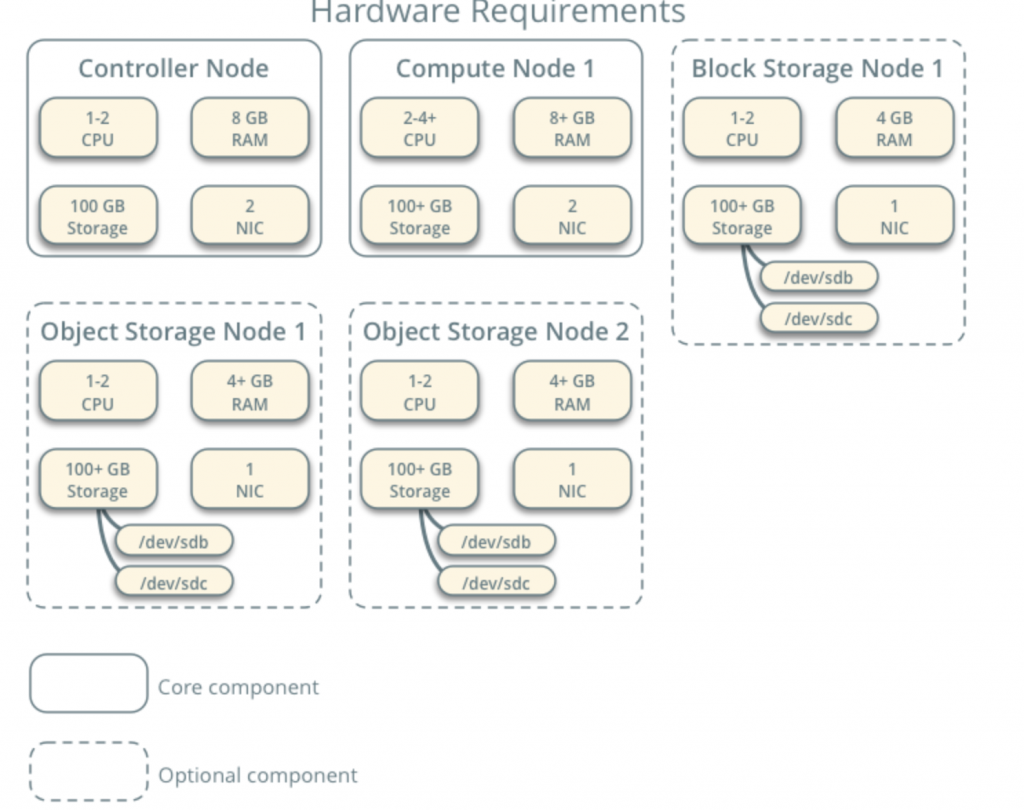

az összes virtuális gépem 4cpu maggal és 8 GB RAM-mal rendelkezik, legalább 120 GB merevlemezzel.A minimális követelményeket itt találja – https://docs.openstack.org/install-guide/overview.html

vegye figyelembe a hálózati és meghajtó komponensek további követelményeit, és adja hozzá a laboratóriumához.

a laboratóriumom rendelkezik internet-hozzáféréssel.

követem az OpenStack dokumentációját az út mentén – https://docs.openstack.org/install-guide/common/conventions.html

telepítem a Vonatépítést, amely a jelenlegi. Kezdjük az 1. vezérlő csomóponttal és az 1. csomópont kiszámításával.

a Szolgáltató hálózata a következő lesz (ehhez a konfigurációhoz internet – hozzáférésre van szükség):

10.0.0.1/24 – átjáró

10.0.0.11/24 – vezérlő csomópont 1

10.0.0.31/24 – számítási csomópont 1

10.0.0.41/24-blokk tároló csomópont 1

10.0.0.51/24-Object Storage Node 1

10.0.0.52 / 24-Object Storage Node 2

én is később létre hálózat tartományban 203.0.113.0/24, hogy lesz management network.

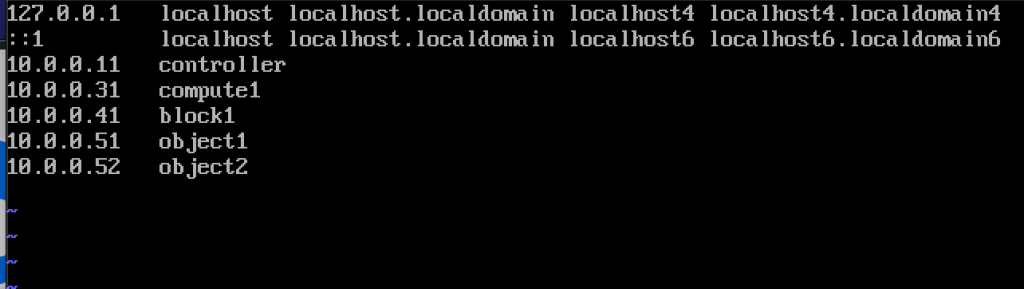

itt is a nevét és IP-címét a gépek (akkor is szükség van rájuk a hosts fájl):

10.0.0.11 vezérlő

10.0.0.31 compute1

10.0.0.41 block1

10.0.0.51 object1

10.0.0.52 object2

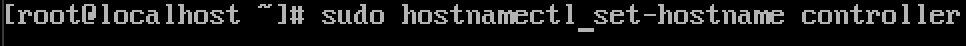

gépnév módosítása

a laborban lévő minden géphez gépnév módosítása. Meg fogom változtatni a hosztneveimet azokra a nevekre, amelyeket éppen ezen felül adtam meg.

parancs alatt, vezérlő a neve az egyik gép, változtassa meg, amit jónak lát.

sudo hostnamectl set-hostname controller

így néz ki a változás az újraindítás után.

a gépeimet – controller, compute1, block1, object1, object2-nek neveztem el.

névfeloldás konfigurálása

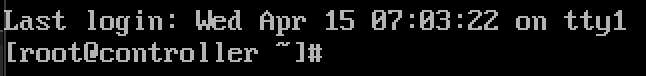

szerkessze az /etc/sysconfig/network-scripts fájlban található hálózati interfészt

esetemben ifcfg-ens33 interfésszel Rendelkezem

sudo vi /etc/sysconfig/network-scripts/ifcfg-ens33a következő sorokat szerkesztettem (vezérlőgép példa):

BOOTPROTO=noneIPADDR=10.0.0.11PREFIX=24GATEWAY=10.0.0.1DNS1=10.0.0.1DNS2=8.8.8.8ONBOOT=yesIPV6INIT=noígy néz ki

indítsa újra a gépet az IP konfiguráció beállítása után. Ismételje meg ezeket a lépéseket a labor összes gépére (természetesen állítson be mindegyikhez különböző IP-címet).

frissítse a CentOS telepítését

mielőtt tovább mennénk, frissítjük a CentOS telepítéseinket. Így megerősítjük az internetkapcsolatunkat is.

sudo yum update -yHosts fájl szerkesztése

ismét ezt kell tennünk minden gépen. Mi lesz szerkeszteni hosts fájlt, hogy a gépek láthatják egymást a nevét.

sudo vi /etc/hosts/ezt kell beírnunk

10.0.0.11 controller10.0.0.31 compute110.0.0.41 block110.0.0.51 object110.0.0.52 object2így néz ki a fájlom

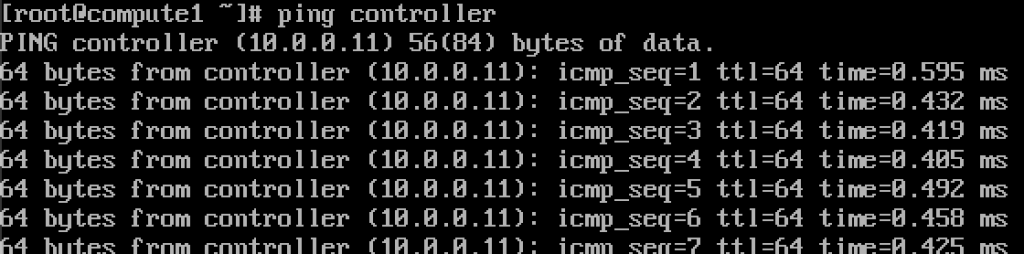

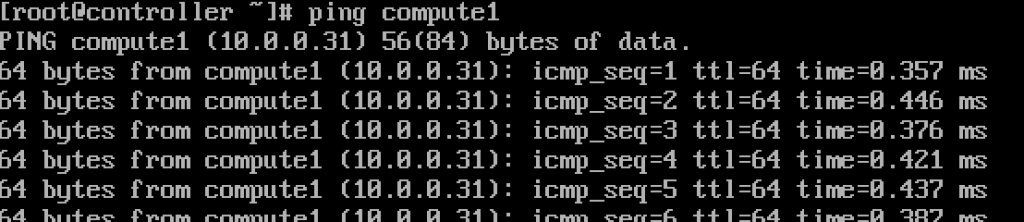

ha mindent rendben csináltunk, akkor most már képesek leszünk pingelni a vezérlőről a compute1-re, és fordítva a névvel. (Győződjön meg róla, hogy a ping elérhető a tűzfalon keresztül)

működik.Írja be ezeket az értékeket minden gép minden hosts fájljába, és győződjön meg róla, hogy minden gépet pingelhet, és minden gépről tesztelhet.

NTP szolgáltatás beállítása

a pontos időmérés fontos, ezért beállítjuk az időszervert, és klienseket csatolunk hozzá. Az időszerver lesz a vezérlő szerverünk és az összes többi gép kliense.

NTP szerver beállítása

ezt a vezérlő szerverünkön fogjuk megtenni.

sudo yum install chrony -yengedélyezze és indítsa el a szolgáltatást a futtatással

sudo systemctl start chronydsudo systemctl enable chronyda szolgáltatás állapotát a futtatással is ellenőrizheti

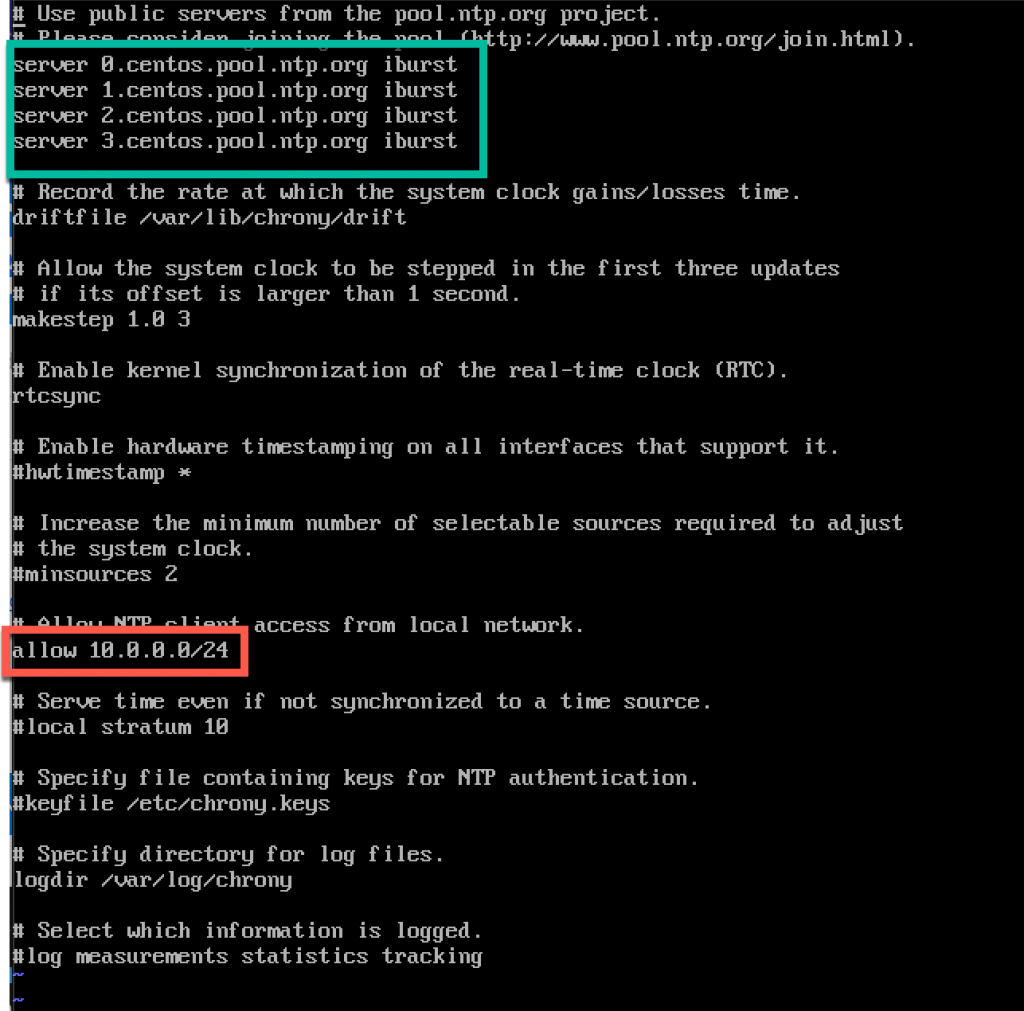

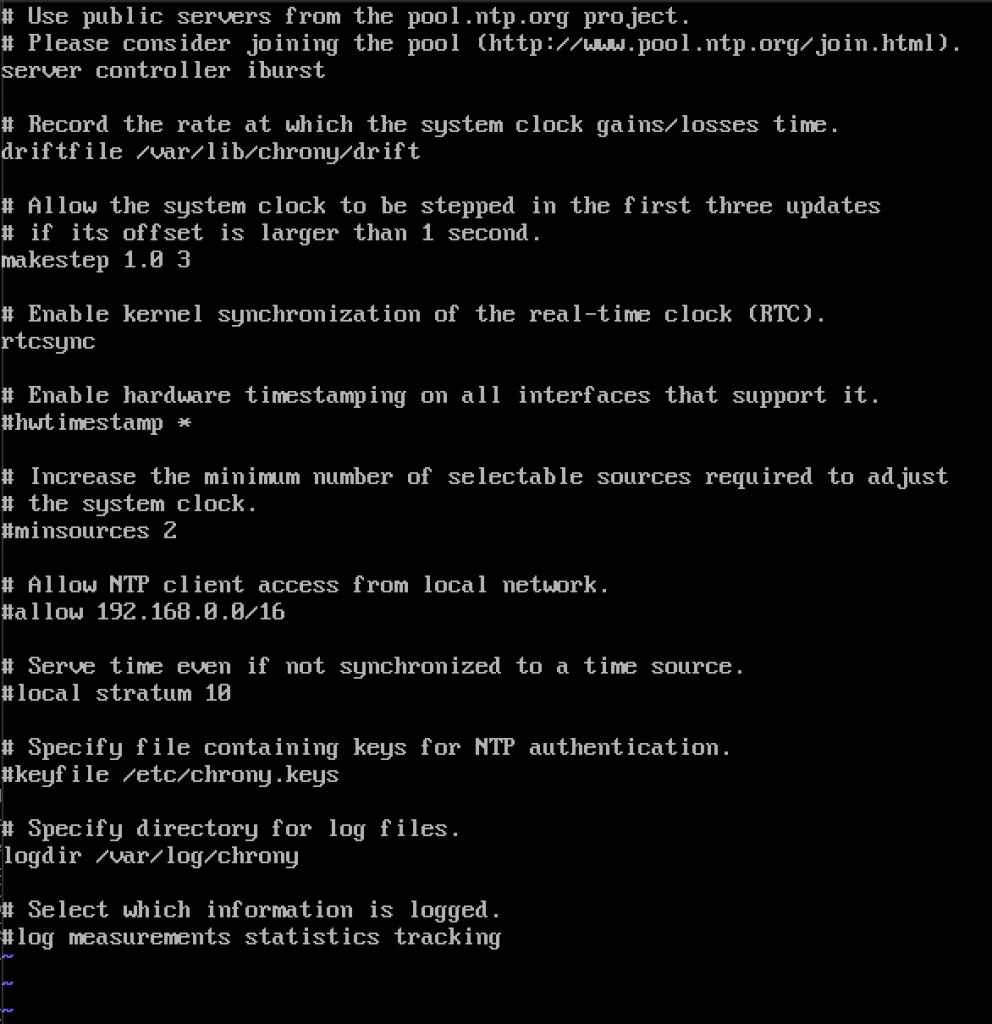

systemctl status chronydezután szerkesztjük az /etc/chrony fájlt.conf fájl

sudo vi /etc/chrony.confehhez az oktatóanyaghoz hagyom az alapértelmezett centos NTP szervereket. Ellenkező esetben, ha szeretné szerkeszteni NTP szerverek, akkor, hozzáadásával alábbi parancsot (cserélje Ntp_server NTP szerver neve)

server NTP_SERVER iburstis meg kell engedélyezni a hozzáférést a mi NTP kliensek a helyi hálózaton uncommenting and editing following line

allow 10.0.0.0/24itt van a config. A zöld rész az, ahol belép az NTP-kiszolgálókba, a piros rész pedig a helyi hálózatról engedélyezett hozzáférést biztosít az időszinkronizáláshoz.

indítsa újra a szervert vagy a chrony szolgáltatást a

sudo systemctl restart chronyda

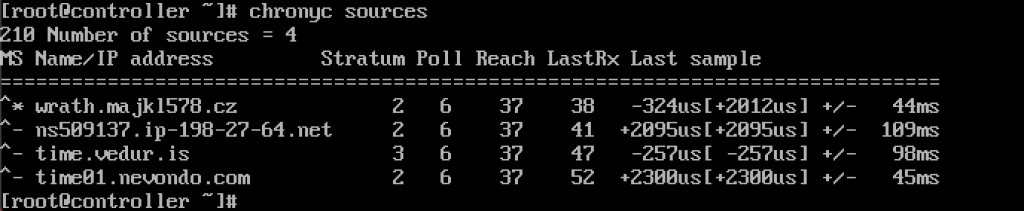

chronyc sources

a szolgáltatás nekem működik.

tűzfalon keresztül is engedélyezzük

sudo firewall-cmd --permanent --add-service=ntpsudo firewall-cmd --reloadNTP kliensek beállítása

ezeket a lépéseket a többi gépen el kell végezni.

ismét telepítenünk kell a chrony-t

sudo yum install chronyengedélyezze és indítsa el az NTP szolgáltatást

sudo systemctl start chronydsudo systemctl enable chronydezután újra meg kell szerkesztenünk az /etc/chrony fájlt.conf

sudo vi /etc/chrony.conftörölnie kell az összes NTP-kiszolgálót, és be kell írnia a következőt

server controller ibursthagyjon mindent úgy, ahogy van, majd zárja be a fájlt. Az enyém így néz ki.

ismét indítsa újra az NTP szolgáltatást

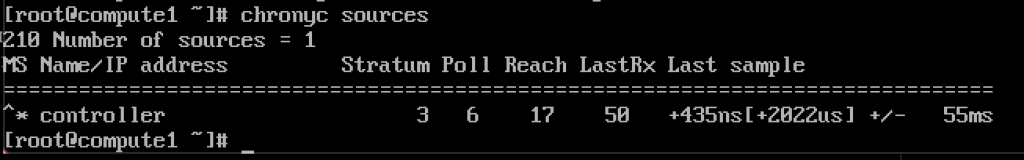

sudo systemctl restart chronydés ellenőrizzük, hogy működik-e

chronyc sources

működik, az ügyfél kommunikál az NTP szerverrel.

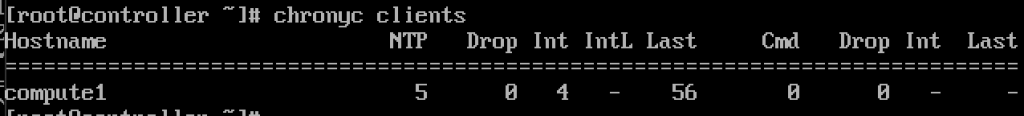

és az NTP szerveren, ha megadjuk a parancsot

chronyc clientslátni fogjuk, hogy a compute1 NTP kliens

ismételje meg a lépést a többi gépen.

OpenStack csomagok

ezeket a lépéseket minden csomóponton el kell végezni. Ha még nem frissítette a CentOS telepítését, tiltsa le az EPEL Repo alkalmazást is.

!!!///Csak RED HAT telepítések esetén a CENTOS kihagyja ezt

subscription-manager repos --enable=rhel-7-server-optional-rpms \ --enable=rhel-7-server-extras-rpms --enable=rhel-7-server-rh-common-rpmsfuttassa a következő parancsot (telepítjük a vonat kiadását)

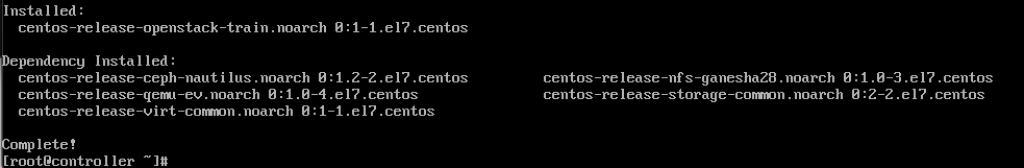

sudo yum install centos-release-openstack-train

a következő parancsot futtatjuk:

sudo yum upgradeindítsa újra utána, majd válassza az új kernel lehetőséget az aktiváláshoz.

a következő parancs a következő lesz:

sudo yum install python-openstackclientés végre integrálnunk kell az OpenStack install-t a SELinux-ba

sudo yum install openstack-selinuxSQL Database

Az adatbázis a controller node-ra lesz telepítve.Telepítjük a MariaDB-t.

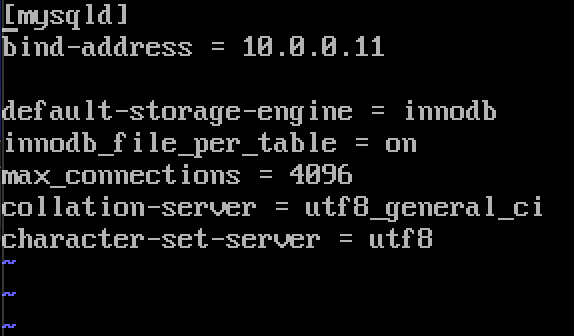

sudo yum install mariadb mariadb-server python2-PyMySQLa telepítés után szerkesztenünk kell egy openstack-et.conf található / etc / én.cnf.d

sudo vi /etc/my.cnf.d/openstack.conflétrehozunk mysqld szakaszt a következő információkkal (győződjön meg róla, hogy a bind-address a vezérlő címe)

bind-address = 10.0.0.11default-storage-engine = innodbinnodb_file_per_table = onmax_connections = 4096collation-server = utf8_general_cicharacter-set-server = utf8így néz ki az én esetemben

a MariaDB engedélyezése és indítása

sudo systemctl enable mariadb.servicesudo systemctl start mariadb.servicetűzfal kivételt is hozzáadunk

sudo firewall-cmd --permanent --add-service=mysqlsudo firewall-cmd --reloadvégül biztosítjuk a telepítést és beállítjuk a root SQL jelszavát felhasználó

sudo mysql_secure_installationüzenetsor

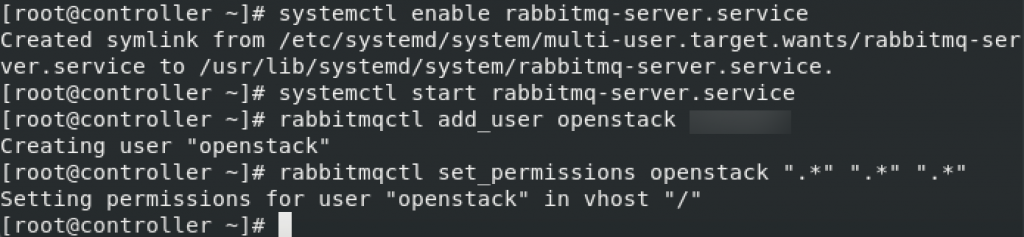

az OpenStack az üzenetsorot használja a szolgáltatások közötti műveletek és státusz koordinálása. Általában a vezérlőn fut, ezért telepítjük a vezérlőre. Telepítjük a RabbitMQ-t

telepítés

sudo yum install rabbitmq-serverszolgáltatás indítása és engedélyezése

sudo systemctl enable rabbitmq-server.servicesudo systemctl start rabbitmq-server.serviceadd hozzá az openstack felhasználót. Cserélje ki a RABBIT_PASS jelszót.

sudo rabbitmqctl add_user openstack RABBIT_PASSEngedélyek beállítása

rabbitmqctl set_permissions openstack ".*" ".*" ".*"

Ezek a RabbitMQ tűzfalbeállításai

sudo firewall-cmd --zone=public --permanent --add-port=4369/tcp --add-port=25672/tcp --add-port=5671-5672/tcp --add-port=15672/tcp --add-port=61613-61614/tcp --add-port=1883/tcp --add-port=8883/tcpsudo firewall-cmd --reloadopcionális SELinux parancs

setsebool -P nis_enabled 1memcached

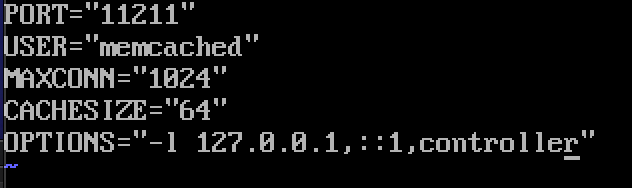

a szolgáltatások Identity Service hitelesítési mechanizmusa Memcached-et használ a tokenek gyorsítótárazásához. A memcached szolgáltatás általában a vezérlő csomóponton fut, ezért telepítem a vezérlő csomópontra.

Installation

sudo yum install memcached python-memcachedNext, we will edit /etc/sysconfig/memcached

sudo vi /etc/sysconfig/memcachedcontroller should be added to OPTIONS line, like this

OPTIONS="-l 127.0.0.1,::1,controller"

At last, we will enable and start service

sudo systemctl enable memcached.servicesudo systemctl start memcached.serviceOptional firewall settings for memcached

sudo firewall-cmd --new-zone=memcached --permanentsudo firewall-cmd --zone=memcached --add-port=11211/udp --permanentsudo firewall-cmd --zone=memcached --add-port=11211/tcp --permanentsudo firewall-cmd --zone=memcached --add-source=10.0.0.0/24 --permanentsudo firewall-cmd --reloadEtcd

Short explanation from docs.openstack.az org-OpenStack szolgáltatások használhatják az Etcd-t, egy elosztott megbízható kulcsérték-tárolót az elosztott kulcszároláshoz, a konfiguráció tárolásához, a szolgáltatás élességének nyomon követéséhez és más forgatókönyvekhez.

Etcd kell telepíteni vezérlő csomópont.

telepítés

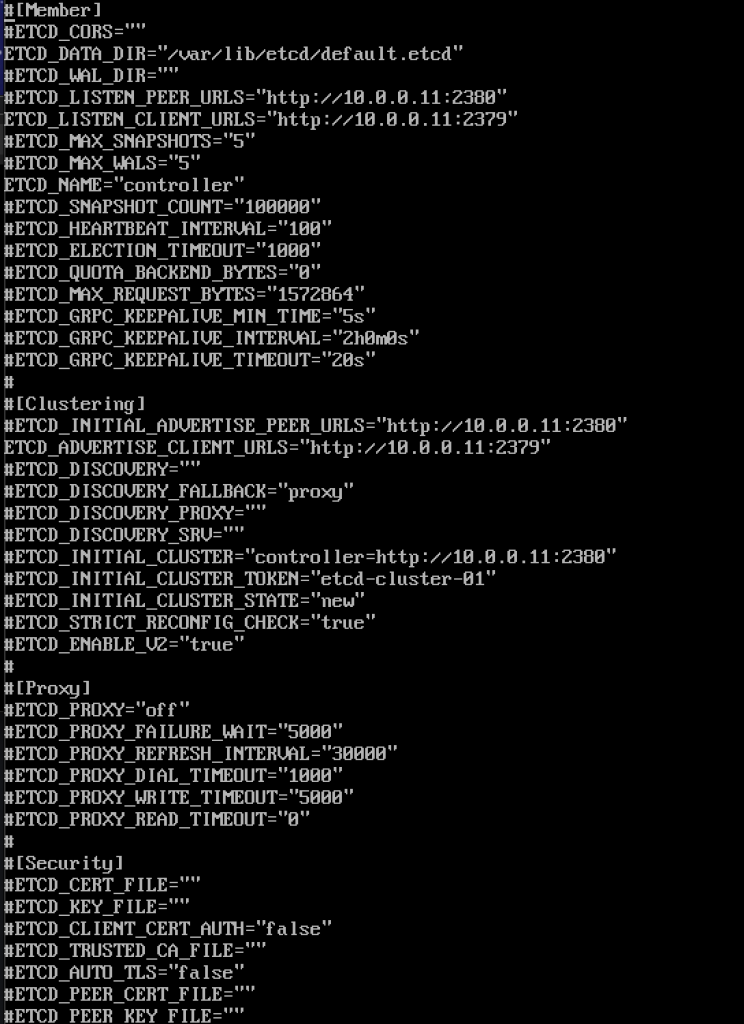

sudo yum install etcdezután szerkesztjük az/etc/etcd / etcd fájlt.conf

sudo vi /etc/etcd/etcd.confa fájlt így kell szerkesztenie, és az alábbi értékeket úgy kell módosítania, hogy megfeleljen a vezérlő IP-címének vagy nevének.

#ETCD_DATA_DIR="/var/lib/etcd/default.etcd"ETCD_LISTEN_PEER_URLS="http://10.0.0.11:2380"ETCD_LISTEN_CLIENT_URLS="http://10.0.0.11:2379"ETCD_NAME="controller"#ETCD_INITIAL_ADVERTISE_PEER_URLS="http://10.0.0.11:2380"ETCD_ADVERTISE_CLIENT_URLS="http://10.0.0.11:2379"ETCD_INITIAL_CLUSTER="controller=http://10.0.0.11:2380"ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster-01"ETCD_INITIAL_CLUSTER_STATE="new"így néz ki a fájlom

szolgáltatás engedélyezése és indítása

sudo systemctl enable etcdsudo systemctl start etcdtovábbi tűzfal beállítások

sudo firewall-cmd --add-port={2379,2380}/tcp --permanentsudo firewall-cmd --reloadtehát, mi többé-kevésbé “kész” initiall része, akkor most csinál minimális telepítési vonat.

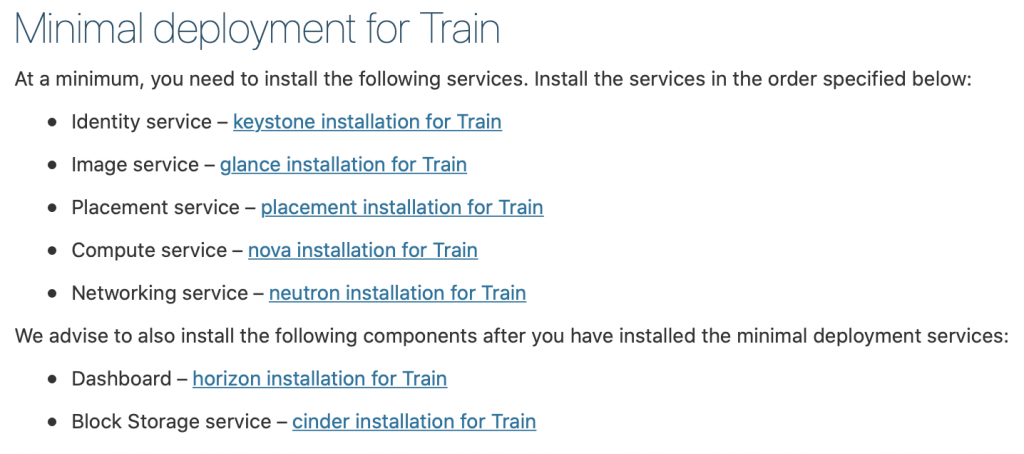

minimális telepítési vonat

Ok, így voltak sikeresek eddig. Mi most csinál minimális szolgáltatás telepítését vonat. További részletek itt találhatók – https://docs.openstack.org/install-guide/openstack-services.html

a szolgáltatásokat meghatározott sorrendben kell telepíteni, mint az alább látható

mivel ez a bemutató megy egy kicsit hosszú már, megyek, hogy befejezze itt, és fedezze az egyes szolgáltatások felett külön bemutató.

fontos dolog az, hogy az összes szolgáltatást pontos sorrendben végezzük, ahogy az alábbiakban vannak.

itt találhatók a linkek

- Identity service – keystone installation for Train

2. Image service-pillantás telepítés vonat

3. Elhelyezés szolgáltatás-elhelyezés telepítés vonat

4. Compute service-nova telepítés vonat

5. Hálózati szolgáltatás – Neutron telepítés vonathoz

javasoljuk, hogy a minimális telepítési szolgáltatások telepítése után telepítse a következő összetevőket is:

6. Műszerfal-horizon telepítés vonat

7. Blokk tárolási szolgáltatás-salak telepítés vonat

8. Object Storage service – swift installation for Train

Additional links for after installation for errors you may encounter:

Disclaimer